6月15日(金)に渋谷で行われた「Bash In Tokyo」にて、急遽作成した音声認識コマンド実行プログラムをデモしてきました。

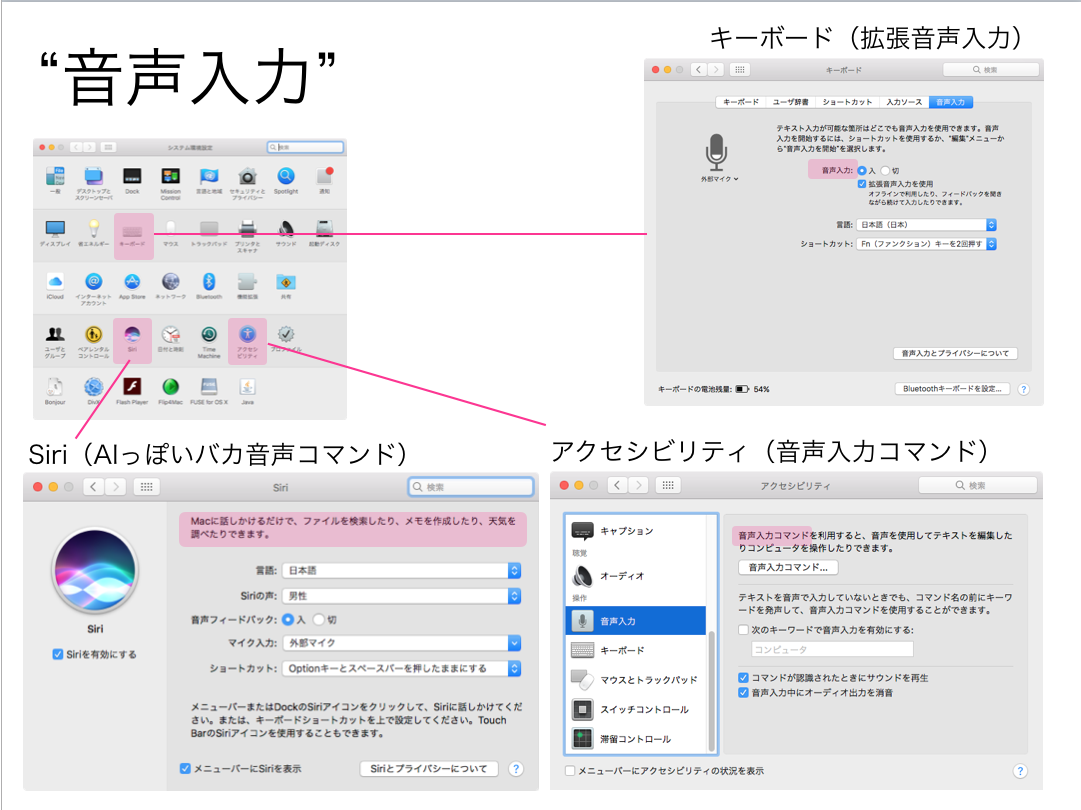

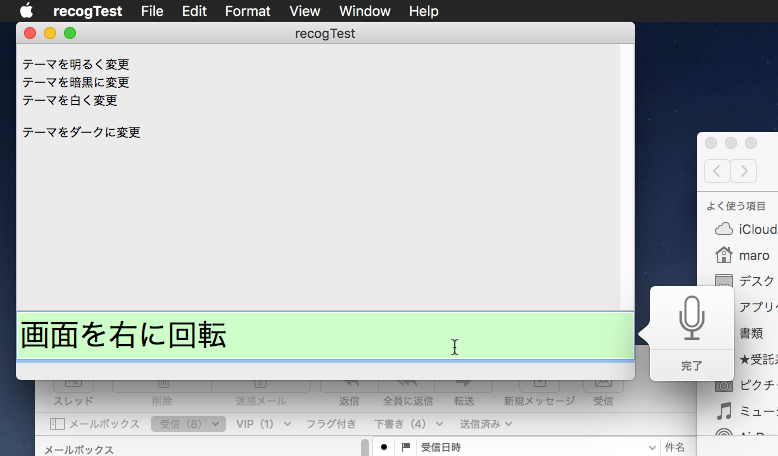

macOSの「音声認識コマンド」と「音声文字入力」の中間のような動きをしていて、シソーラス辞書(同義語辞書)を搭載しているため、パラメータの表現の「ゆらぎ」を許容する構造になっています。

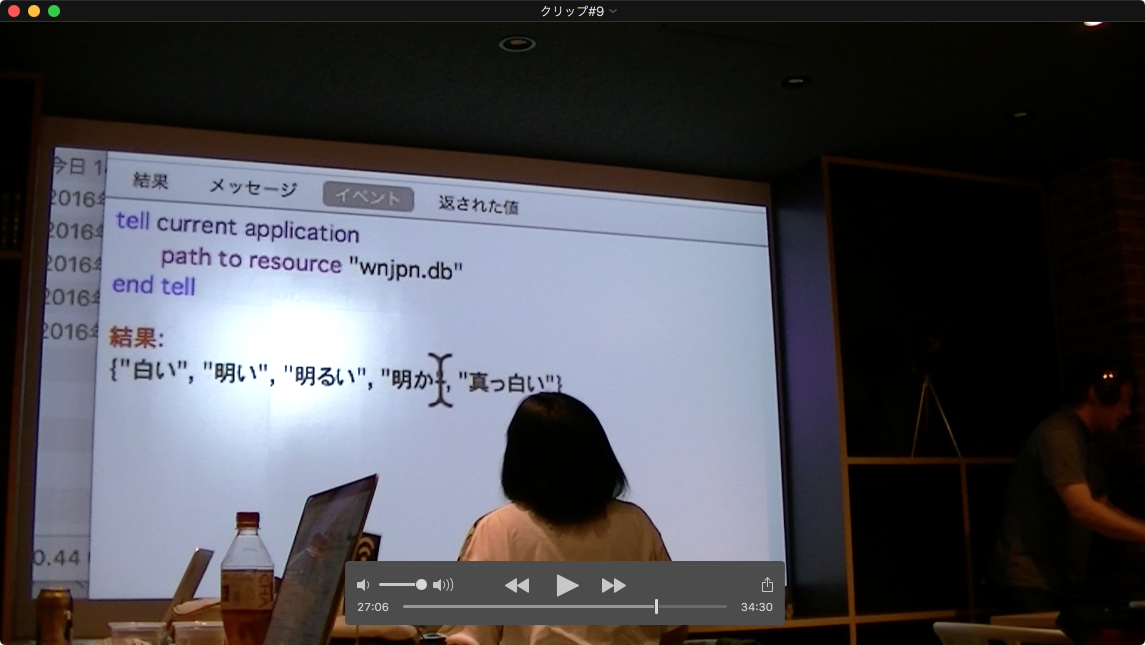

GUI部分はXcode上のAppleScriptのプロジェクトであり、呼び出されるコマンド側も(編集可能な)AppleScriptのファイルです。現段階では、コマンド側のAppleScriptのファイル名にコマンドとパラメータを記述してあり、音声認識したテキストを形態素解析して、コマンドやパラメータに該当する品詞の単語をピックアップし、コマンド側の単語とのマッチングを行います。

本プログラムを作成する前に「Web APIでチャットボットなんか使えば楽をできるのでは?」と考えて調査はしてみたものの、結論からいえば「雑談暇つぶしボットぐらいしかできない」という印象でした。お金をかけて作り込めばMicrosoft Bot Frameworkにしても、NTT Communicatins 「COTOHA」にしても使えるとは思うのですが、特定のコマンドキーワードを認識したあとは急に業務系アプリっぽい挙動になったり、コマンド実行の演出とかはとくにないので、「自分で作ったほうがマシ」だということに、、、、デモの前日に気づきました。

# つまり、プログラムのコア部分は1日かけずに作ったという、、、、

もうちょっと調整して何かのデモに使ってみたいところです。

(Visited 76 times, 1 visits today)